| Développons en Java 2.30 | |

| Copyright (C) 1999-2022 Jean-Michel DOUDOUX | (date de publication : 15/06/2022) |

|

|

|

|

|

| Niveau : | |

En programmation fonctionnelle, on décrit le résultat souhaité mais pas comment on obtient le résultat. Ce sont les fonctionnalités sous-jacentes qui se chargent de réaliser les traitements requis en tentant de les exécuter de manière optimisée.

Ce mode de fonctionnement est similaire à SQL : le langage SQL permet d'exprimer une requête mais c'est le moteur de la base de données qui choisir la meilleure manière d'obtenir le résultat décrit. Comme avec SQL, la manière dont on exprime le résultat peut influencer la manière dont le résultat va être obtenu notamment en termes de performance.

Java 8 propose l'API Stream pour mettre en oeuvre une approche de la programmation fonctionnelle sachant que Java est et reste un langage orienté objet.

Le concept de Stream existe déjà depuis longtemps dans l'API I/O, notamment avec les interfaces InputStream et OutputStream. Il ne faut pas confondre l'API Stream de Java 8 avec les classes de type xxxStream de Java I/O. Les streams de Java I/O permettent de lire ou écrire des données dans un flux (sockets, fichiers, ...). Le concept de Stream de Java 8 est différent du concept de flux (stream) de l'API I/O même si l'approche de base est similaire : manipuler un flux d'octets ou de caractères pour l'API I/O et manipuler un flux de données pour l'API Stream. Cette dernière repose sur le concept de flux (stream en anglais) qui est une séquence d'éléments.

L'API Stream facilite l'exécution de traitements sur des données de manière séquentielle ou parallèle. Les Streams permettent de laisser le développeur se concentrer sur les données et les traitements réalisés sur cet ensemble de données sans avoir à se préoccuper de détails techniques de bas niveau comme l'itération sur chacun des éléments ou la possibilité d'exécuter ces traitements de manière parallèle.

L'API Stream de Java 8 propose une approche fonctionnelle dans les développements avec Java. Elle permet de décrire de manière concise et expressive un ensemble d'opérations dont le but est de réaliser des traitements sur les éléments d'une source de données. Cette façon de faire est complètement différente de l'approche itérative utilisée dans les traitements d'un ensemble de données avant Java 8.

Ceci permet au Stream de pouvoir :

L'API Stream permet de réaliser des opérations fonctionnelles sur un ensemble d'éléments. De nombreuses opérations de l'API Stream attendent en paramètre une interface fonctionnelle ce qui conduit naturellement à utiliser les expressions lambdas et les références de méthodes dans la définition des Streams. Un Stream permet donc d'exécuter des opérations standards dont les traitements sont exprimés grâce à des expressions lambdas ou des références de méthodes.

Un Stream permet d'exécuter une agrégation d'opérations de manière séquentielle ou en parallèle sur une séquence d'éléments obtenus à partir d'une source dans le but d'obtenir un résultat.

| Exemple ( code Java 8 ) : |

double tailleMoyenneDesHommes = employes

.stream()

.filter(e -> e.getGenre() == Genre.HOMME)

.mapToInt(e -> e.getTaille())

.average()

.orElse(0); |

Dans l'exemple ci-dessus, une collection d'éléments de type Employe est utilisée comme source pour un Stream qui va effectuer des opérations de type filter-map-reduce pour calculer la moyenne de la taille des personnes de sexe masculin. La moyenne calculée par la méthode average() est une opération dite de réduction.

Le code utilisé est :

Les éléments traités par le Stream sont fournis par une source qui peut être de différents types :

Avec l'API Stream il est possible de déclarer de manière concise des traitements sur une source de données qui seront exécutés de manière séquentielle ou parallèle. Le traitement en parallèle d'un ensemble de données requiert plusieurs opérations :

Java 7 propose le framework Fork/Join pour faciliter la mise en oeuvre de ces opérations en parallèle. L'API Stream utilise ce framework pour l'exécution des traitements en parallèle.

L'utilisation de l'API Stream possède donc plusieurs avantages :

Ce chapitre contient plusieurs sections :

Il est fréquent dans les applications de devoir manipuler un ensemble de données. Pour stocker cet ensemble de données, Java propose, depuis sa version 1.1, l'API Collections.

Différentes évolutions ont permis de rendre de plus en plus expressif le code pour traiter ces données. Celles-ci vont être illustrées dans les exemples ci-dessous à l'aide d'un petit algorithme qui va calculer la somme des valeurs inférieures à 10 dans une collection contenant les 12 premiers entiers.

Avec Java 5, il est possible d'utiliser un Iterator avec les generics.

| Exemple ( code Java 5.0 ) : |

List<Integer> entiers = Arrays.asList(1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12);

Iterator<Integer> it = entiers.iterator();

long somme = 0;

while (it.hasNext()) {

int valeur = it.next();

if (valeur < 10) {

somme += valeur;

}

}

System.out.println(somme); |

Java 5 a aussi introduit une nouvelle syntaxe de l'instruction for qui permet de faciliter l'écriture du code requis pour parcourir une collection

| Exemple ( code Java 5.0 ) : |

long somme = 0;

for (int valeur : entiers) {

if (valeur < 10) {

somme += valeur;

}

}

System.out.println(somme); |

Dans les exemples précédents, le parcours des éléments de la collection est fait à la main sous la forme d'une itération externe (external iteration) qui contient la logique de traitements. Finalement le code à produire pour réaliser cette tâche relativement simple est assez important.

Java 8 propose la méthode forEach() dans l'interface Collection qui attend en paramètre une interface fonctionnelle de type Consumer.

| Exemple ( code Java 8 ) : |

LongAdder somme = new LongAdder();

entiers.forEach(valeur -> {

if (valeur < 10) {

somme.add(valeur);

}

});

System.out.println(somme); |

Dans les exemples précédents, le code de l'algorithme est exécuté séquentiellement. Il serait beaucoup plus complexe et verbeux pour arriver à le faire exécuter en parallèle (en imaginant que le volume de données à traiter soit beaucoup plus important).

L'ajout du support de traitement en parallèle dans l'API Collections aurait été très compliqué : le choix a été fait de définir une nouvelle API permettant de :

Pour offrir une solution à cette problématique et proposer la possibilité de simplifier la réalisation d'opérations plus ou moins complexes sur des données, Java 8 propose l'API Stream.

| Exemple ( code Java 8 ) : |

long somme = entiers.stream()

.filter(v -> v <10)

.mapToInt(i -> i)

.sum();

System.out.println(somme); |

Elle permet notamment très facilement d'exécuter ces traitements en parallèle.

| Exemple ( code Java 8 ) : |

long somme = entiers.parallelStream()

.filter(v -> v < 10)

.mapToInt(i -> i)

.sum();

System.out.println(somme); |

L'approche proposée par Java 8 est de laisser l'API réaliser l'itération (internal iteration).

L'utilisation de l'API Stream permet de se concentrer sur l'essentiel (la logique des traitements) et de l'exprimer sous une forme expressive et succincte. L'exemple de traitement tient maintenant sur une ligne de code.

Ainsi avant Java 8, la seule manière de traiter les éléments d'une collection est d'itérer sur ceux-ci généralement en utilisant un Iterator explicitement en utilisant une boucle while ou implicitement en utilisant une boucle de type for each. Cette approche est celle de la programmation impérative avec laquelle il est nécessaire de coder toutes les étapes de l'algorithme à utiliser. Généralement cela implique une écriture verbeuse du code de ces traitements puisque celui-ci détaille ce que doivent faire les fonctionnalités. Dans la plupart des cas, il serait moins verbeux de décrire les résultats attendus et de laisser l'application exécuter à sa manière les fonctionnalités correspondantes.

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

import java.util.ArrayList;

import java.util.List;

public class TestBoucle {

public static void main(String[] args) {

List<Personne> personnes = new ArrayList<>(6);

personnes.add(new Personne("p1", Genre.HOMME, 176));

personnes.add(new Personne("p2", Genre.HOMME, 190));

personnes.add(new Personne("p3", Genre.FEMME, 172));

personnes.add(new Personne("p4", Genre.FEMME, 162));

personnes.add(new Personne("p5", Genre.HOMME, 176));

personnes.add(new Personne("p6", Genre.FEMME, 168));

long total = 0;

int nbPers = 0;

for (Personne personne : personnes) {

if (personne.getGenre() == Genre.FEMME) {

nbPers++;

total += personne.getTaille();

}

}

double resultat = (double) total / nbPers;

System.out.println("Taille moyenne des femmes = " + resultat);

}

} |

Les traitements de l'exemple précédent peuvent être réécrits en utilisant l'API Stream.

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

import java.util.ArrayList;

import java.util.List;

public class TestBoucle {

public static void main(String[] args) {

List<Personne> personnes = new ArrayList<>(6);

personnes.add(new Personne("p1", Genre.HOMME, 176));

personnes.add(new Personne("p2", Genre.HOMME, 190));

personnes.add(new Personne("p3", Genre.FEMME, 172));

personnes.add(new Personne("p4", Genre.FEMME, 162));

personnes.add(new Personne("p5", Genre.HOMME, 176));

personnes.add(new Personne("p6", Genre.FEMME, 168));

resultat = personnes

.stream()

.filter(p -> p.getGenre() == Genre.FEMME)

.mapToInt(p -> p.getTaille())

.average()

.getAsDouble();

System.out.println("Taille moyenne des femmes = " + resultat);

}

} |

Dans l'exemple ci-dessus, les données traitées par le Stream subissent plusieurs opérations :

L'API Stream propose donc d'ajouter une manière plus expressive et une approche fonctionnelle au langage Java pour le traitement de données :

L'interface Stream<T> propose une liste définie d'opérations qu'il sera possible de réaliser. La plupart de ces opérations renvoient une instance de type Stream<T> pour permettre de combiner ces opérations.

L'API Stream est contenue dans le package java.util.stream. Ce package est composée de 10 interfaces, deux classes et une énumération.

Les interfaces de l'API sont :

|

Interface |

Description |

|

BaseStream<T,S extends BaseStream<T,S>> |

Interface de base pour les Streams |

|

Collector<T,A,R> |

Interface pour une opération de réduction qui accumule les éléments dans un conteneur mutable avec éventuellement une transformation du résultat un fois tous les éléments traités |

|

DoubleStream |

Un Stream dont la séquence est composée d'éléments de primitif double |

|

DoubleStream.Builder |

Un builder pour un DoubleStream |

|

IntStream |

Un Stream dont la séquence est composée d'éléments de primitif int |

|

IntStream.Builder |

Un builder pour un IntStream |

|

LongStream |

Un Stream dont la séquence est composée d'éléments de primitif long |

|

LongStream.Builder |

Un builder pour un LongStream |

|

Stream<T> |

Un stream dont la séquence est composée d'éléments de type T |

|

Stream.Builder<T> |

Un builder pour un Stream |

L'interface BaseStream<T,S extends BaseStream<T,S>> est l'interface mère des principales interfaces utilisées :

Si les éléments du Stream sont des données numériques alors il n'est pas recommandé d'utiliser un Stream<T> où T est de type Double, Long ou Integer. Les opérations sur ces objets vont nécessiter de l'autoboxing. Dans ces cas, il est préférable d'utiliser un DoubleStream, IntStream ou LongStream pour améliorer les performances des traitements de ces données et profiter de certaines opérations de réductions dédiés aux type primitifs tels que la somme ou la moyenne.

L'API définit plusieurs classes :

|

Classe |

Description |

|

Collectors |

Propose plusieurs fabriques pour obtenir des implémentations de l'interface Collector qui implémentent des opérations de réduction communes |

|

StreamSupport |

Propose des méthodes de bas niveau pour créer des Streams à partir d'un Spliterator fourni en paramètre |

Il est très fréquent de vouloir traiter des données stockées dans une collection. Cependant, l'exécution de traitements sur une collection présente plusieurs inconvénients :

| Exemple ( code Java 7 ) : |

List<Employe> employeMasculins = new ArrayList<>();

for (Employe e : employes) {

if (e.getGenre() == Genre.HOMME) {

employeMasculins.add(e);

}

}

Collections.sort(employeMasculins, new Comparator<Employe>() {

@Override

public int compare(Employe p1, Employe p2) {

return p2.getTaille() - p1.getTaille();

}

});

List<String> nomEmployes = new ArrayList<>();

for (Personne p : employeMasculins) {

nomEmployes.add(p.getNom());

}

for (String nom : nomEmployes) {

System.out.println(nom);

} |

Un Stream peut être vu comme une abstraction qui permet de réaliser des opérations définies sur un ensemble de données.

Le but principal d'un Stream est de pouvoir décrire de manière expressive des traitements à exécuter sur un ensemble de données en limitant au maximum le code à produire pour y arriver. Globalement cela passe par une description de ce que l'on veut faire mais pas comment cela va se faire.

De la même manière que SQL permet de définir les données à obtenir et la façon dont on souhaite qu'elles soient restituées, les Streams permettent de décrire des opérations à réaliser sur un ensemble de données.

La déclaration d'un Stream se fait en plusieurs étapes :

| Exemple ( code Java 8 ) : |

List<String> nomEmployes =

employes.stream()

.filter(e -> e.getGenre() == Genre.HOMME)

.sorted(Comparator.comparingInt(Employe::getTaille)

.reversed())

.map(Personne::getNom)

.collect(Collectors.toList());

for (String nom : nomEmployes) {

System.out.println(nom);

} |

Le code Java 8 est plus compact car il ne contient que les informations indispensables à la bonne exécution des traitements :

De plus, comme la manière d'exécuter ces traitements est laissée à l'implémentation du Stream, il est possible que celui-ci les exécute en parallèle sur simple demande en remplaçant la méthode stream() par parallelStream().

| Exemple ( code Java 8 ) : |

List<String> nomEmployes =

employes.parallelStream()

.filter(e -> e.getGenre() == Genre.HOMME)

.sorted(Comparator.comparingInt(Employe::getTaille)

.reversed())

.map(Personne::getNom)

.collect(Collectors.toList());

for (String nom : nomEmployes) {

System.out.println(nom);

} |

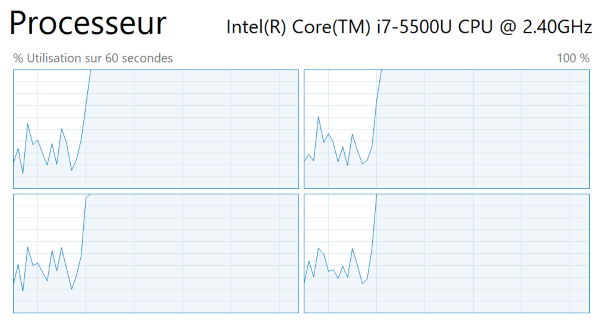

Un Stream parallèle va en interne paralléliser l'exécution du pipeline d'opérations en répartissant les données sur plusieurs threads pour utiliser les coeurs présents sur la machine.

Une définition simple d'un Stream pourrait être : « l'application d'un ensemble d'opérations sur une séquence d'éléments issus d'une source dans le but d'obtenir un résultat ».

Cette définition met en avant plusieurs concepts :

De plus, un Stream utilise d'autres concepts lors de sa mise en oeuvre :

Un Stream permet d'exécuter des opérations sur un ensemble de données obtenues à partir d'une source afin de générer un résultat.

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

import java.util.Arrays;

import java.util.List;

public class JavaApplication1 {

public static void main(String[] args) {

List<String> maListe = Arrays.asList("a1", "a2", "b2", "b1", "c1");

maListe.stream()

.filter(s -> s.startsWith("b"))

.map(String::toUpperCase)

.sorted()

.forEach(System.out::println);

}

} |

| Résultat : |

B1

B2 |

Il existe deux types d'opérations : les opérations intermédiaires et les opérations terminales. L'ensemble des opérations effectuées par un Stream est appelé pipeline d'opérations (operation pipeline).

La plupart des opérations d'un Stream attendent en paramètre une interface fonctionnelle pour définir leur comportement. Ces paramètres peuvent ainsi être exprimés en utilisant une expression lambda ou une référence de méthode.

Une opération peut être avec ou sans état.

Il est important que :

Les opérations d'un Stream permettent de décrire des traitements, potentiellement complexes, à exécuter sur un ensemble de données. Elles sont définies dans l'interface java.util.stream.Stream grâce à de nombreuses méthodes.

Il existe deux catégories d'opérations :

Les opérations intermédiaires ne réalisent aucun traitement tant que l'opération terminale n'est invoquée. Elles sont dites lazy ce qui permettra éventuellement d'effectuer des optimisations dans leur exécution comme car exemple de réaliser celle-ci dans une même itération.

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

import java.util.Arrays;

import java.util.List;

import static java.util.stream.Collectors.toList;

public class TestStream2 {

public static void main(String[] args) {

List<Integer> nombres = Arrays.asList(1, 2, 3, 4, 5, 6, 7, 8);

List<Integer> troisPremierNombrePairAuCarre =

nombres.stream()

.filter(n -> {

System.out.println("filter " + n);

return n % 2 == 0;

})

.map(n -> {

System.out.println("map " + n);

return n * n;

})

.limit(3)

.collect(toList());

System.out.println("");

troisPremierNombrePairAuCarre.forEach(System.out::println);

}

} |

| Résultat : |

filter 1

filter 2

map 2

filter 3

filter 4

map 4

filter 5

filter 6

map 6

4

16

36 |

Dans l'exemple ci-dessus, plusieurs optimisations sont mises en oeuvre par le Stream. Tous les éléments ne sont pas parcourus. Les opérations ne sont invoquées que le nombre de fois requis sur des éléments pour obtenir le résultat :

Ceci est possible car l'opération limit(3) ne renvoie qu'un Stream qui contient au maximum le nombre d'éléments précisé en paramètre.

Les opérations sont regroupées en une seule itération qui traite chaque élément en lui appliquant le pipeline d'opérations : les opérations n'itèrent pas individuellement sur les éléments du Stream.

Ceci permet d'optimiser au mieux les traitements à réaliser pour obtenir le résultat de manière efficiente.

L'utilisation d'un Stream implique généralement trois choses :

Les opérations proposées par un Stream sont des opérations communes :

Pour filtrer des données, un Stream propose plusieurs opérations :

Pour rechercher une correspondance avec des éléments, un Stream propose plusieurs opérations :

Pour transformer des données, un Stream propose plusieurs opérations :

Pour réduire les données et produire un résultat, un Stream propose plusieurs opérations :

Il est tentant de voir un Stream comme une collection. Les notions de collections et de Streams concernent toutes les deux une séquence d'éléments. De manière grossière, une collection permet de stocker cette séquence d'éléments et un Stream permet d'exécuter des opérations sur cette séquence d'éléments.

Bien que les Collections et les Streams semblent avoir des similitudes, ils ont des objectifs différents :

Les Streams diffèrent donc de plusieurs manières des Collections :

Une collection est une structure qui stocke un ensemble de données en mémoire. Les traitements sur une collection, sans utiliser les Streams, nécessitent de réaliser une itération sur tout ou partie des éléments de la collection par exemple en utilisant l'instruction for.

| Exemple ( code Java 5.0 ) : |

List<Personne> personnes = // ... code pour obtenir une liste de personnes

List<Long> ids = new ArrayList<>(personnes.size());

for(Personne p: personnes){

ids.add(p.getId());

} |

Avec un Stream, les opérations à réaliser sont décrites mais l'itération ou les itérations pour exécuter ces traitements sont réalisées en interne lors de l'exécution de la méthode terminale du Stream.

| Exemple ( code Java 8 ) : |

List<Personne> personnes = // ... code pour obtenir une liste de personnes

List<Long> ids = personne.stream()

.map(Personne::getId)

.collect(toList()); |

Le code ci-dessus décrit simplement les opérations à réaliser par le Stream. La façon dont ces traitements seront exécutés est à la charge de l'implémentation du Stream.

Dans les deux exemples, le résultat est le même.

Les collections sont des structures en mémoire qui permettent de stocker des données : toutes les valeurs doivent être ajoutées à la collection avant de pouvoir les traiter. Un Stream ne stocke pas de données : il va obtenir les données à traiter à la demande à partir d'une source. Il effectue des traitements sur les données de cette source sur la base de l'exécution d'un pipeline d'opérations.

Le fait que l'API Stream réalise elle-même en interne l'itération sur les éléments de la source de données permet que la plupart des opérations soient exécutés de manière lazy. Ceci permet à l'API de réaliser éventuellement des optimisations.

Un Stream est un consommable : il consomme les données de la source une fois que son opération terminale est invoquée.

Un Stream peut assurer un traitement séquentiel ou en parallèle de ces traitements : le traitement en parallèle peut être très intéressant d'un point de vue performance notamment dans le cas du traitement d'un gros volume de données.

La création d'un Stream se fait nécessairement à partir d'une source de données. Cette source va permettre de fournir les différents éléments à la demande du Stream pour pouvoir les traiter.

Les Streams peuvent utiliser des données issues d'une source finie ou infinie d'éléments.

Il existe différentes façons de construire un Stream à partir de différentes sources :

Il est aussi possible d'utiliser une Function pour produire un nombre infini d'éléments comme source de données.

Chacune des classes pouvant servir de source propose une ou plusieurs méthodes pour créer un Stream :

|

Méthode |

Source |

|

stream() ou parallelStream() d'une Collection |

Les éléments de la collection Stream<String> chaines = Arrays.asList("a1", "a2", "a3").stream(); |

|

Stream<T> Arrays.stream(T[]) |

Les éléments du tableau String[] valeurs = {"a1", "a2", "a3"}; Stream<String> chaines = Arrays.stream(valeurs); |

|

Stream<T> Stream.of(T) |

L'élément |

|

Stream<T> Stream.of(T.) |

Les éléments passés en paramètre dans le varargs Stream<Integer> stream = Stream.of(1,2,3,4); |

|

IntStream.range(int, int) |

Les valeurs entières incluse entre les bornes inférieure et supérieure exclue fournies |

|

IntStream.rangeClosed(int, int) |

Les valeurs entières incluse entre les bornes inférieures et supérieures fournies |

|

Stream<T> Stream.iterate(T, UnaryOperator<T>) |

Des valeurs générées en appliquant successivement la fonction à partir de la valeur initiale fournie en paramètres Stream<Integer> stream = Stream.iterate(0, (i) -> i + 1); |

|

Stream.empty() |

Aucun élément |

|

Stream.generate(Supplier<T>) |

Un nombre infini d'éléments créés par le Supplier fourni en paramètre Stream<UUID> stream = Stream.generate(UUID::randomUUID); |

|

Stream<String> BufferedReader.lines() |

Les lignes d'un fichier texte |

|

Stream<String> Files.lines |

Les lignes d'un fichier texte |

|

IntStream Random.ints() |

Un nombre infini d'entiers aléatoires |

|

IntStream BitSet.stream() |

Les indices des bits positionnés à 1 dans le BitSet |

|

Stream<String> Pattern.splitAsStream(CharSequence) |

Les chaînes de caractères issues de l'application du motif String str = "chaine1,chaine2,chaine3"; Pattern.compile(",") .splitAsStream(str) .forEach(System.out::println); |

|

ZipFile.stream() JarFile.stream() |

Les éléments contenus dans l'archive |

|

IntStream String.chars |

Les caractères de la chaîne Remarque le Stream obtenu est de type IntStream IntStream stream = "abcdef".chars(); |

Il est également possible que des sources soient proposées par des bibliothèques tierces ou soient développées par ses propres soins.

L'interface Stream propose plusieurs fabriques pour créer un Stream.

La méthode of() de l'interface Stream attend en paramètre un varargs d'objets.

| Exemple ( code Java 8 ) : |

Stream<Integer> stream = Stream.of(new Integer[] { 1, 2, 3}); |

Attention, ce sont des objets qui sont attendus. Il n'est donc pas possible de fournir en paramètre un tableau de type entier primitif.

| Exemple ( code Java 8 ) : |

Stream<Integer> stream = Stream.of(new int[] { 1, 2, 3}); |

| Résultat : |

C:\java\workspace\TestStreams\src>javac com/jmdoudoux/dej/streams/TestStream.java

com\jmdoudoux\dej\streams\TestStream.java:9:

error: incompatible types: inference variable T has incompatible bounds

Stream<Integer> stream1 = Stream.of(new int[] { 1, 2, 3 });

^

equality constraints: Integer

lower bounds: int[]

where T is a type-variable:

T extends Object declared in method <T>of(T)

1 error |

Il est cependant possible de passer en paramètre de la méthode of() de l'interface IntStream un tableau d'entiers primitifs.

| Exemple ( code Java 8 ) : |

IntStream stream = IntStream.of(new int[] { 1, 2, 3}); |

Les méthodes iterate() et generate() de l'interface Stream attendent en paramètre une Function. Les éléments générés sont calculés à la demande en invoquant la fonction pour générer la prochaine valeur. Sans contrainte particulière, cette génération se poursuit à l'infini. Dans ce cas, on parle de Stream infini : c'est un Stream dont la source ne connait pas le nombre d'éléments qui sera traité à l'avance.

Par exemple, la méthode iterate() attend en paramètre une valeur initiale et un UnaryOperator qui sera invoqué pour générer chaque nouvelle valeur.

| Exemple ( code Java 8 ) : |

Stream<Integer> entiers = Stream.iterate(0, n -> n + 1);

entiers.forEach(System.out::println); |

Ce traitement va incrémenter une valeur entière et l'afficher sur la console.

Il est bien sûr possible de définir une condition d'arrêt des traitements du Stream basée sur le nombre d'éléments traités en utilisant la méthode limit() avec en paramètre le nombre souhaité.

| Exemple ( code Java 8 ) : |

Stream<Integer> entiers = Stream.iterate(0, n -> n + 1);

entiers.limit(10)

.forEach(System.out::println); |

Les traitements sur les données d'une collection doivent être réalisés en itérant explicitement sur chacun des éléments. Avec les Streams l'itération est effectué par les traitements de l'API.

L'interface Collection propose deux méthodes pour obtenir un Stream dont la source sera la collection :

|

Méthode |

Rôle |

|

default Stream<E> stream() |

Renvoyer un Stream dont les traitements seront exécutés de manière séquentielle sur les éléments de la collection |

|

default Stream<E> parallelStream() |

Renvoyer un stream dont les traitements sont exécutés en parallèle sur les éléments de la collection |

Un Stream peut donc être obtenu à partir de n'importe quelle implémentation de l'interface Collection en utilisant la méthode stream().

| Exemple ( code Java 8 ) : |

List<String> elements = new ArrayList<String>();

elements.add("element1");

elements.add("element2");

elements.add("element3");

Stream<String> stream = elements.stream(); |

Un Stream exécute une combinaison d'opérations pour former un pipeline.

Les opérations sont des méthodes définies dans l'interface Stream :

La plupart des opérations d'un Stream attendent en paramètres une interface fonctionnelle qui sont généralement définies dans le package java.util.function. Cela permet d'utiliser une expression Lambda pour décrire les traitements qui seront réalisés par l'opération.

Le traitement de données par un Stream se fait en deux étapes :

Remarque : aucun traitement n'est effectué lors de l'invocation des méthodes intermédiaires. Ces méthodes sont dites lazy.

Dès qu'une méthode terminale est invoquée, le Stream est considéré comme consommé et plus aucune de ces méthodes ne peut être invoquée. Une méthode terminale peut produire une ou plusieurs valeurs ou opérer des effets de bord (forEach).

L'exemple ci-dessous créé une liste des 5 premières personnes dont le nom commence par un 'A'.

| Exemple ( code Java 8 ) : |

List<String> prenomsCommencantParA = personnes

.stream()

.map(Personne::getNom)

.filter(nom->nom.startsWith("a"))

.limit(5)

.collect(Collectors.toList()); |

Cet exemple utilise trois opérations intermédiaires :

L'opération terminale collect() transforme les résultats de l'exécution dans une collection de type List.

Les opérations d'un Stream sont réparties en deux catégories :

Une opération intermédiaire produit et renvoie un objet de type Stream. Ces opérations peuvent donc être chaînées pour définir le pipeline d'opérations.

Le traitement de ces méthodes n'est pas exécuté tant qu'une méthode terminale n'est pas invoquée. L'invocation d'une méthode intermédiaire permet simplement d'ajouter l'opération au pipeline : seule l'invocation de l'opération terminale va lancer la récupération des données et leur utilisation au travers du pipeline d'opérations.

Chaque opération intermédiaire :

La plupart de ces opérations intermédiaires d'un Stream fonctionnent en mode lazy : il diffère le plus tardivement ses traitements jusqu'à ce que les résultats soient nécessaires. Le mode lazy permet des optimisations, par exemple : il n'est pas nécessaire de parcourir tous les éléments pour trouver le premier qui correspondent à un critère donné. Ce type d'optimisation est particulièrement utile notamment si le nombre d'éléments à traiter est important

Il est important de comprendre que les opérations intermédiaires s'exécutent en mode lazy. Leur invocation ne provoque aucun traitement : c'est l'invocation de la méthode terminale qui provoque le traitement des données par les opérations du Stream.

Ce mode de fonctionnement possède plusieurs avantages :

Pour illustrer ce comportement, l'exemple ci-dessous utilise un Stream sur une collection de prénoms pour les mettre en majuscule, ne conserver que ceux qui commencent par un 'A' et ne prendre que les deux premiers pour les afficher.

| Exemple ( code Java 8 ) : |

prenoms.stream()

.map(String::toUpperCase)

.filter(p -> p.startsWith("A"))

.limit(2)

.forEach(System.out::println); |

| Résultat : |

ANDRE

ALBERT |

Bien que l'opération limit() soit la dernière opération intermédiaire, elle a une influence sur l'exécution. Une fois que la condition est atteinte (deux prénoms commençant par A) alors les traitements effectués par le Stream sont interrompus. Ceci est possible car le pipeline d'opérations est appliqué sur chaque donnée.

| Exemple ( code Java 8 ) : |

public static void main(String[] args) {

List<String> prenoms = Arrays.asList("andre", "benoit", "albert", "thierry", "alain",

"jean");

prenoms.stream()

.map(p -> {

afficher("map ", p);

return p.toUpperCase();})

.filter(p -> {

afficher("filter ", p);

return p.startsWith("A");})

.peek(p -> {

afficher("limit ", p);})

.limit(2)

.forEach(System.out::println);

}

public static void afficher(String message, String p) {

System.out.println(message + " : " + p);

} |

| Résultat : |

map : andre

filter : ANDRE

limit : ANDRE

ANDRE

map : benoit

filter : BENOIT

map : albert

filter : ALBERT

limit : ALBERT

ALBERT |

Cette façon d'exécuter les traitements permet d'améliorer les performances notamment lorsque la quantité de donnée est importante. Au lieu de réaliser la transformation et le filtre sur toutes les données pour ne conserver que les trois premières, elles sont appliquées sur les données jusqu'à ce que la condition soit respectée.

Un pipeline d'opérations doit impérativement se terminer par une opération terminale.

Les opérations terminales lancent les traitements du Stream pour produire le résultat de l'exécution du pipeline d'opérations ou des effets de bords sur les données consommées :

Une fois qu'une méthode terminale est invoquée, elle lance les traitements et le Stream ne pourra alors plus être utilisé. Une fois que l'opération terminale est exécutée, le Stream est considéré comme consommé et il ne peut plus être utilisé. Si les données de la source doivent de nouveau être parcourues, il faut obligatoirement recréer un nouveau Stream à partir de la source.

Les opérations terminales ont pour rôle de terminer le pipeline d'opérations :

Certaines méthodes intermédiaires (limit(), skip(), ...) ou terminales (anyMatch(), allMatch(), noneMatch(), findFirst(), findAny(), ...) sont de type « short-circuiting » :

Si le pipeline contient une opération de type short-circuiting, les méthodes intermédiaires suivantes ne seront exécutées que lorsque la méthode short circuit pourra être évaluée.

Avoir une opération de type short-circuit dans le pipeline du Stream est une condition nécessaire mais pas toujours suffisante pour permettre de terminer l'exécution d'un Stream dont le nombre d'éléments est infini.

Une opération intermédiaire renvoit toujours un Stream.

Le pipeline d'opérations d'un Stream peut avoir zéro, une ou plusieurs opérations intermédiaires.

Les opérations intermédiaires peuvent être réparties en deux groupes :

L'API Stream définit plusieurs opérations intermédiaires :

|

Opération |

Rôle |

|

|

filter |

Stateless |

Stream<T> filter(Predicate<? super T> predicate) |

|

map |

Stateless |

<R> Stream<R> map(Function<? super T,? extends R> mapper) |

|

mapToxxx(Int, Long or Double) |

Stateless |

xxxStream mapToxxx(ToxxxFunction<? super T> mapper) Renvoyer un Stream qui contient le résultat de la transformation de chaque élément de type T en un type primitif xxx |

|

flatMap |

Stateless |

<R> Stream<R> flatMap(Function<T,Stream<? extends R>> mapper) |

|

flatMapToxxx (Int, Long or Double) |

xxxStream flatMapToxxx(Function<? super T,? extends xxxStream> mapper) Renvoyer un Stream avec l'ensemble des éléments contenus dans les xxxStream retournés par l'application de la Function sur les éléments de type T. Ainsi chaque élément de type T peut renvoyer zéro, un ou plusieurs éléments de type primitif xxx. |

|

|

distinct |

Stateful |

Stream<T> distinct() Renvoyer un Stream<T> dont les doublons ont été retirés. La détection des doublons se fait en invoquant la méthode equals() |

|

sorted |

Stateful |

Stream<T> sorted() Stream<T> sorted(Comparator<? super T>) Renvoyer un Stream dont les éléments sont triés dans un certain ordre. La surcharge sans paramètre tri dans l'ordre naturel : le type T doit donc implémenter l'interface Comparable car c'est sa méthode compareTo() qui est utilisée pour la comparaison des éléments deux à deux La surcharge avec un Comparator l'utilise pour déterminer l'ordre de tri. |

|

peek |

Stateless |

Stream<T> peek(Consumer <? super T>) Renvoyer les éléments du Stream et leur appliquer le Consumer fourni en paramètre |

|

limit |

Stateful Short-Circuiting |

Stream<T> limit(long) Renvoyer un Stream qui contient au plus le nombre d'éléments fournis en paramètre |

|

skip |

Stateful |

Stream<T> skip(long) Renvoyer un Stream dont les n premiers éléments ont été ignorés, n correspondant à la valeur fournie en paramètre |

|

sequential |

Stream<T> sequential() Renvoyer un Stream équivalent dont le mode d'exécution des opérations est séquentiel |

|

|

parallel |

Stream<T> parallel() Renvoyer un Stream équivalent dont le mode d'exécution des opérations est en parallèle |

|

|

unordered |

Stream<T> parallel() Renvoyer un Stream équivalent dont l'ordre des éléments n'a pas d'importance |

|

|

onClose |

Stream<T> onClose(Runnable) Renvoyer un Stream équivalent dont le handler fourni en paramètre sera exécuté à l'invocation de la méthode close(). L'ordre d'exécution de plusieurs handlers est celui de leur déclaration. Tous les handlers sont exécutés même si un handler précédent à lever une exception. |

Les opérations sans état (stateless) comme map() ou filter() renvoient simplement le résultat de l'exécution sur l'élément courant dans le Stream pour être traité par l'opération suivante.

Les opérations avec état (stateful) peuvent avoir besoin de conserver des informations relatives au traitement des éléments précédent voir de tous les éléments pour pouvoir produire le Stream contenant les éléments à traiter par l'opération suivante.

Une opération de mapping permet de réaliser une transformation des éléments traités par le Stream.

Parfois, il est nécessaire de transformer les éléments d'un Stream. La méthode map() permet d'opérer une transformation en passant chacun des éléments du Stream à la Function fournie en paramètre. Le résultat est la production d'un nouveau Stream contenant le résultat de l'application de la fonction à chaque élément. C'est une transformation de type un pour un.

L'interface Stream<T> propose plusieurs opérations pour faire des transformations de type map.

|

Méthode |

Rôle |

|

<R> Stream<R> map(Function<? super T,? extends R> mapper) |

Renvoyer un Stream qui contient le résultat de l'application de la fonction sur chaque élément du Stream. T est le type des éléments du Stream et R est le type des éléments résultat |

|

DoubleStream mapToDouble(ToDoubleFunction<? super T> mapper) |

Renvoyer un DoubleStream contenant le résultat de l'application de la fonction passé en paramètre à tous les éléments du Stream |

|

IntStream mapToInt(ToIntFunction<? super T> mapper) |

Renvoyer un IntStream contenant le résultat de l'application de la fonction passé en paramètre à tous les éléments du Stream |

|

LongStream mapToLong(ToLongFunction<? super T> mapper) |

Renvoyer un LongStream contenant le résultat de l'application de la fonction passé en paramètre à tous les éléments du Stream |

La méthode map(Function< ? super T, ? super R>) attend en paramètre une Function ayant en argument un objet de type T et renvoie un objet de type R. Cette Function va être appliquée sur tous les éléments du Stream pour créer pour chacun un nouvel élément qui sera inclus dans le Stream en résultat. L'implémentation de l'interface fonctionnelle fournie en paramètre doit être :

Important :la modification de la source de données durant l'exécution du pipeline d'opérations peut conduire à un comportement ou un résultat non désiré.

Le type de la valeur de retour de l'opération map() peut être du même type que la valeur traitée ou d'un type différent.

| Exemple ( code Java 8 ) : |

Stream<String> chaines = Stream.of("aaa", "bbb", "ccc");

chaines.map(chaine -> chaine.toUpperCase())

.forEach(System.out::println); |

| Résultat : |

AAA

BBB

CCC |

Les traitements de transformations peuvent être le résultat de l'exécution d'une méthode indiquée grâce à une référence de méthode comme pour toute expression Lambda qui ne consiste qu'à invoquer une méthode.

| Exemple ( code Java 8 ) : |

Stream<String> chaines = Stream.of("aaa", "bbb", "ccc");

chaines.map(String::toUpperCase)

.forEach(System.out::println); |

| Résultat : |

AAA

BBB

CCC |

Cette méthode peut aussi être une méthode contenant des traitements métiers de l'application.

| Exemple ( code Java 8 ) : |

Long[] idEmployes = { 12345L, 67890L };

List<Employe> listeEmployes = Stream

.of(idEmployes)

.map(EmployeeService::rechercherParId)

.collect(Collectors.toList());

System.out.println(listeEmployes); |

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

import java.util.Random;

public class EmployeeService {

private static Random rnd = new Random();

public static Employe rechercherParId(Long id) {

return new Employe("nom " + id,

(id % 2) == 0 ? Genre.HOMME : Genre.FEMME,

150 + rnd.nextInt(50),

1000 + rnd.nextInt(2000));

}

} |

| Résultat : |

[Employe [nom=nom 12345, genre=FEMME, taille=168,

salaire=2573.0], Employe [nom=nom 67890, genre=HOMME, taille=187, salaire=1374.0]] |

La Function peut produire des éléments de types différents du type de l'élément traité.

| Exemple ( code Java 8 ) : |

personnes.stream().map(Personne::getNom).forEach(System.out::println); |

Dans l'exemple ci-dessus, la méthode stream() renvoie un Stream<Personne> sur lequel la méthode map() est appliquée. La Function qui lui est passée est une invocation de la méthode getNom() : la méthode map() renvoie un Stream<String> dont les éléments sont les noms des personnes. Enfin la méthode forEach() exécute le Consumer qui affiche tous les noms sur la console.

Plusieurs transformations peuvent être appliquées dans le pipeline d'opérations

| Exemple ( code Java 8 ) : |

Long[] idEmployes = { 12345L, 67890L };

List<String> listeNomsEmployes = Stream

.of(idEmployes)

.map(EmployeeService::rechercherParId)

.map(e -> e.getNom())

.collect(Collectors.toList());

System.out.println(listeNomsEmployes); |

| Résultat : |

[nom 12345, nom 67890] |

La méthode mapToInt() applique une Function à chaque élément pour produire un IntStream à la place d'un Stream<Integer>

La méthode mapToLong() est similaire à la méthode mapToInt() mais elle renvoie un LongStream.

La méthode mapToDouble() est similaire à la méthode mapToInt() mais elle renvoie un DoubleStream.

Lorsque le résultat de la transformation renvoie une valeur entière ou flottante, il est possible d'utiliser la méthode map() qui va renvoyer un Stream du type du wrapper de la valeur primitive.

| Exemple ( code Java 8 ) : |

Double[] valeurs = { 1.0, 2.0, 3.0, 4.0, 5.0 };

Double[] valeursAuCarre = Stream.of(valeurs).map(v -> v * v).toArray(Double[]::new);

System.out.println(Arrays.deepToString(valeursAuCarre)); |

| Résultat : |

[1.0, 4.0, 9.0, 16.0, 25.0] |

Mais l'utilisation des méthodes mapToDouble(), mapToInt() et mapToLong() améliore les performances essentiellement car elles évitent des opérations coûteuses de boxing et unboxing. Ceci est particulièrement vrai pour très grande quantité d'éléments.

| Exemple ( code Java 8 ) : |

Double[] valeurs = { 1.0, 2.0, 3.0, 4.0, 5.0 };

double[] valeursAuCarre = Stream.of(valeurs)

.mapToDouble(v -> v * v)

.toArray();

System.out.println(Arrays.toString(valeursAuCarre)); |

| Résultat : |

[1.0, 4.0, 9.0, 16.0, 25.0] |

Les opérations map() et flatMap() servent toutes les deux à réaliser des transformations mais il existe une différence majeure :

L'opération map() permet de transformer un élément du Stream mais elle possède une limitation : le résultat de la transformation doit obligatoirement produire un unique élément qui sera ajouté au Stream renvoyé.

L'exemple ci-dessous créé une paire de valeur (valeur -1 et valeur) à partir d'une collection de nombres. La valeur retournée est ainsi une List de List d'Integer.

| Exemple ( code Java 8 ) : |

List<Integer> nombres = Arrays.asList(1, 3, 5, 7, 9);

List<List<Integer>> tuples =

nombres.stream()

.map(nombre -> Arrays.asList(nombre - 1, nombre))

.collect(Collectors.toList());

System.out.println(tuples); |

| Résultat : |

[[0, 1], [2, 3], [4, 5], [6, 7], [8, 9]] |

Le même exemple que précédemment mais utilisant une opération flatMap() renvoie une List d'Integer dont toutes les valeurs ont été mises à plat.

| Exemple ( code Java 8 ) : |

List<Integer> nombres = Arrays.asList(1, 3, 5, 7, 9);

List<Integer> nombresDesTuples =

nombres.stream()

.flatMap(nombre -> Arrays.asList(nombre - 1, nombre).stream())

.collect(Collectors.toList());

System.out.println(nombresDesTuples); |

| Résultat : |

[0, 1, 2, 3, 4, 5, 6, 7, 8, 9] |

L'opération flatMap() transforme chaque élément en un Stream d'autres éléments : ainsi chaque élément va être transformé en zéro, un ou plusieurs autres éléments. Le contenu des Streams issus du résultat de la transformation de chaque objet est agrégé pour constituer le Stream retourné par la méthode flatMap().

L'opération flatMap() attend en paramètre une Function qui renvoie un Stream. La Function est appliquée sur chaque élément qui produit chacun un Stream. Le résultat renvoyé par la méthode est un Stream qui est l'agréation de tous les Streams produits par les invocations de la Function.

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

import java.util.ArrayList;

import java.util.List;

public class Departement {

private String nom;

private List<Etudiant> etudiants = new ArrayList<>();

public Departement(String nom) {

super();

this.nom = nom;

}

public String getNom() {

return nom;

}

public void setNom(String nom) {

this.nom = nom;

}

public List<Etudiant> getEtudiants() {

return etudiants;

}

} |

| Exemple ( code Java 8 ) : |

departements.stream()

.flatMap(d -> d.getEtudiants().stream())

.forEach(System.out::println); |

L'exemple ci-dessous affiche tous les mots d'un fichier texte.

| Exemple ( code Java 8 ) : |

try {

Files.lines(Paths.get("fichier.txt"))

.map(ligne -> ligne.split("\\s+"))

.flatMap(Arrays::stream)

.map(mot -> mot.replaceAll("[^A-Za-z]+", ""))

.distinct()

.forEach(System.out::println);

} catch (IOException e) {

e.printStackTrace();

} |

La méthode lines() renvoie un Stream<String> où chaque élément est une ligne du fichier. La première méthode map() renvoie un Stream<String[]> où chaque élément est un tableau des mots d'un ligne. La méthode flatMap() renvoie un Stream<String> où chaque élément est un mot du fichier

L'exemple ci-dessous créé un Stream à partir d'un Stream de List en utilisant la méthode flatMap().

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

import java.util.Arrays;

import java.util.List;

import java.util.stream.Stream;

public class TestFlatMap {

public static void main(String[] args) {

Stream<List<String>> listesIngredients = Stream.of(Arrays.asList("carottes",

"poireaux", "navets"), Arrays.asList("eau"), Arrays.asList("sel", "poivre"));

Stream<String> ingredients = listesIngredients.flatMap(strList -> strList.stream());

ingredients.forEach(System.out::println);

}

} |

| Résultat : |

carottes

poireaux

navets

eau

sel

poivre |

Il est fréquent de vouloir appliquer un filtre sur les éléments d'un Stream pour ne conserver qu'un sous-ensemble de ces éléments, ceux répondant à un certain critère. L'opération filter() permet de ne conserver que les éléments du Stream qui respecte une certaine condition.

L'interface Stream<T> propose la méthode filter() pour filtrer les éléments du stream :

Stream<T> filter(Predicate<? super T> predicate)

La méthode filter() attend en paramètre une interface fonctionnelle de type Predicate : elle permet de filter les éléments du Stream selon la condition fournie en paramètre par l'interface fonctionnelle de type Predicate. Le Predicate est appliqué sur chaque élément du Stream : s'il renvoie true, élément est ajouté dans le Stream de sortie, sinon l'élément est ignoré.

| Exemple ( code Java 8 ) : |

Listb<String> prenoms = Arrays.asList("andre", "benoit" "albert", "thierry", "alain",

"jean");

prenoms.stream()

.filter(p -> p.startsWith("a"))

.forEach(System.out::println); |

| Résultat : |

andre

albert

alain |

Il est possible d'utiliser plusieurs opérations filter() dans un même pipeline d'opérations.

| Exemple ( code Java 8 ) : |

List<String> prenoms = Arrays.asList("andre", "benoit","albert", "thierry", "alain",

"jean");

prenoms.stream()

.filter(p -> p.startsWith("a"))

.filter(p -> p.length() == 5)

.forEach(System.out::println); |

| Résultat : |

andre

alain |

Il est cependant préférable de regrouper les filtres lorsque cela est possible.

| Exemple ( code Java 8 ) : |

List<String> prenoms = Arrays.asList("andre", "benoit","albert", "thierry", "alain",

"jean");

prenoms.stream()

.filter(p -> p.startsWith("a") && (p.length() == 5))

.forEach(System.out::println); |

| Résultat : |

andre

alain |

L'opération distinct() permet de supprimer les doublons contenus dans un Stream. Les éléments contenus dans le Stream retournés sont donc uniques. La méthode distinct() n'attend aucun paramètre et renvoie un Steam avec les éléments dont les doublons ont été retirés.

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

import java.io.PrintStream;

import java.util.Arrays;

import java.util.List;

public class TestStream {

public static void main(String[] args) {

List<Integer> entiers = Arrays.asList(1, 2, 3, 1, 2, 3);

entiers.stream()

.distinct()

.forEach(System.out::println);

}

} |

| Résultat : |

1

2

3 |

La détection des doublons est réalisée en utilisant la méthode equals() des éléments. Il est donc important que celle-ci soit correctement implémentée.

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

public class MaClasse {

private String nom;

public MaClasse(String nom) {

this.nom = nom;

}

public String getNom() {

return nom;

}

@Override

public boolean equals(Object obj) {

if (this == obj) {

return true;

}

if (obj == null) {

return false;

}

if (getClass() != obj.getClass()) {

return false;

}

MaClasse other = (MaClasse) obj;

if (nom == null) {

if (other.nom != null) {

return false;

}

} else if (!nom.equals(other.nom)) {

return false;

}

return true;

}

// implémentation de la méthode hashCode() en correspondance

// volontairement non fournie pour illustrer la problématique engendrée

@Override

public String toString() {

return "MaClasse [nom=" + nom + "]";

}

} |

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

import java.io.PrintStream;

import java.util.Arrays;

import java.util.List;

public class TestStream {

public static void main(String[] args) {

List<MaClasse> maClasses = Arrays.asList(new MaClasse("aaa"), new MaClasse("bbb"), new

MaClasse("aaa"));

maClasses.stream()

.distinct()

.forEach(System.out::println);

}

} |

| Résultat : |

MaClasse [nom=aaa]

MaClasse [nom=bbb]

MaClasse [nom=aaa] |

La méthode distinct() ne donne pas le résultat attendu bien que la méthode equals() soit implémentée. Cela est dû est fait qu'en Java, il faut implémenter la méthode hashCode() en correspondance avec l'implémentation de la redéfinition de la méthode equals().

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

public class MaClasse {

private String nom;

public MaClasse(String nom) {

this.nom = nom;

}

public String getNom() {

return nom;

}

@Override

public int hashCode() {

final int prime = 31;

int result = 1;

result = (prime * result) + ((nom == null) ? 0 : nom.hashCode());

return result;

}

@Override

public boolean equals(Object obj) {

if (this == obj) {

return true;

}

if (obj == null) {

return false;

}

if (getClass() != obj.getClass()) {

return false;

}

MaClasse other = (MaClasse) obj;

if (nom == null) {

if (other.nom != null) {

return false;

}

} else if (!nom.equals(other.nom)) {

return false;

}

return true;

}

@Override

public String toString() {

return "MaClasse [nom=" + nom + "]";

}

} |

| Résultat : |

MaClasse [nom=aaa]

MaClasse [nom=bbb] |

Cette opération intermédiaire est stateful : elle nécessite de stocker tous les éléments qui seront renvoyés : cela peut donc requérir une quantité de mémoire dépendante du nombre d'éléments traités par le Stream. Tous les éléments du Stream en entrée doivent être traités avant qu'un premier élement ne soit envoyés dans le Stream de retour.

Si le Stream est ordonné, l'élément conservé parmi les doublons est toujours le premier. Si le Stream n'est pas ordonné, l'élément conservé parmi les doublons n'est pas prédictible.

L'utilisation d'un Stream non ordonné ou l'utilisation de la méthode unordered() peut améliorer les performances lors de l'utilisation de distinct() dans un Stream parallèle, sous réserve que le contexte le permette. Si l'ordre doit être préservé, il arrive qu'un Stream séquentiel puisse être plus performant qu'un Stream parallèle équivalent.

L'opération intermédiaire limit() permet de limiter le nombre d'éléments contenu dans le Stream retourné. Le nombre d'éléments est passé en paramètre de la méthode limit().

C'est une opération de type short-circuit : dès que le nombre d'éléments contenus dans le Stream retourné est atteint, l'opération met fin à la consommation d'éléments de la source par le Stream.

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

import java.io.PrintStream;

import java.util.Arrays;

import java.util.List;

public class TestStream {

public static void main(String[] args) {

List<Integer> entiers = Arrays.asList(1, 2, 3, 4, 5, 6);

entiers.stream()

.limit(3)

.forEach(System.out::println);

}

} |

| Résultat : |

1

2

3 |

L'opération skip() permet d'ignorer un certain nombre d'éléments du Stream. Les premiers éléments du Stream sont ignorés, les autres sont ajoutés dans le Stream retourné par la fonction. Si le nombre d'éléments fournis en paramètre est supérieur ou égal au nombre d'éléments du Stream, alors le Stream retourné est vide.

La méthode skip() attend en paramètre une valeur entière qui correspond au nombre d'éléments à ignorer.

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

import java.io.PrintStream;

import java.util.Arrays;

import java.util.List;

public class TestStream {

public static void main(String[] args) {

List<Integer> entiers = Arrays.asList(1, 2, 3, 4, 5, 6);

entiers.stream()

.skip(3)

.forEach(System.out::println);

}

} |

| Résultat : |

4

5

6 |

L'opération sorted() permet de trier les éléments du Stream : elle renvoie donc un Stream dont les éléments sont triés. Elle utilise un tampon qui doit avoir tous les éléments avant de pouvoir effectuer le tri.

Par défaut, la méthode sorted() sans paramètre utilise l'ordre naturel des éléments.

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

import java.util.Arrays;

import java.util.List;

public class TestStream {

public static void main(String[] args) {

List<String> prenoms = Arrays.asList("andre", "benoit", "albert", "thierry", "alain");

prenoms.stream()

.sorted()

.forEach(System.out::println);

}

} |

| Résultat : |

alain

albert

andre

benoit

thierry |

Une surcharge de la méthode sorted() attend en paramètre un Comparator qui sera utilisé pour comparer les éléments deux à deux lors du tri.

| Exemple ( code Java 8 ) : |

List<String> prenoms = Arrays.asList("andre", "benoit","albert", "thierry", "alain");

prenoms.stream()

.sorted(Comparator.reverseOrder())

.forEach(System.out::println); |

| Résultat : |

thierry

benoit

andre

albert

alain |

Il est possible de construire des Comparator évolués en utilisant les méthodes static et par défaut de l'interface Comparator.

| Exemple ( code Java 8 ) : |

List<String> prenoms = Arrays.asList("andre", "benoit", "albert", "thierry", "alain");

prenoms.stream()

.sorted(Comparator.comparingInt(String::length)

.thenComparing(Comparator.naturalOrder())

.reversed())

.forEach(System.out::println); |

| Résultat : |

thierry

benoit

lbert

andre

alain |

L'opération peek() renvoie un Stream contenant tous les éléments du Stream courant en appliquant le Consumer fournit en paramètre sur chacun des éléments.

Le but de cette opération est essentiellement le débogage, par exemple pour afficher l'élément en cours de traitement.

| Exemple ( code Java 8 ) : |

List<String> prenoms = Arrays.asList("andre", "benoit", "albert", "thierry", "alain",

"jean");

prenoms.stream()

.map(p -> {

afficher("map ", p);

return p.toUpperCase();

})

.filter(p -> {

afficher("filter ", p);

return p.startsWith("A");

})

.peek(p -> {

afficher("limit ", p);

})

.limit(2)

.forEach(System.out::println); |

| Résultat : |

map : andre

filter : ANDRE

limit : ANDRE

ANDRE

map : benoit

filter : BENOIT

map : albert

filter : ALBERT

limit : ALBERT

ALBERT

ANDRE |

Important : le Consumer ne devrait pas modifier l'élément ni la source du Stream.

Plusieurs méthodes sont des opérations intermédiaires qui modifient certaines caractéristiques du Stream et donc peuvent avoir un impact sur la manière dont le Stream va traiter les données.

La méthode sequential() permet de demander l'exécution des traitements du Stream en séquentiel dans un seul thread.

La méthode parallel() permet de demander l'exécution des traitements du Stream en parallèle en utilisant plusieurs threads du pool Fork/Join.

Les méthodes sequential() et parallel() sont des opérations intermédiaires : elles permettent donc simplement de configurer les traitements qui seront effectivement exécutés par l'invocation de la méthode terminale. Les traitements ainsi exécutés ne peuvent l'être dans leur intégralité qu'en séquentiel ou en parallèle même si les méthodes sequential() et parallel() sont invoqués dans le Stream.

| Exemple ( code Java 8 ) : |

Stream.of(1, 3, 4, 2)

.parallel()

.sorted()

.peek((v) -> System.out.println(Thread.currentThread()

.getName() + " " + v))

.sequential()

.forEach((v) -> System.out.println(Thread.currentThread()

.getName() + " " + v)); |

| Résultat : |

main 1

main 1

main 2

main 2

main 3

main 3

main 4

main 4 |

C'est l'état indiqué par la dernière méthode sequential() ou parallel() qui sera utilisée pour déterminer le mode d'exécution des traitements du Stream.

| Exemple ( code Java 8 ) : |

Stream.of(1, 3, 4, 2)

.sequential()

.sorted()

.peek((v) -> System.out.println(Thread.currentThread()

.getName() + " " + v))

.parallel()

.forEach((v) -> System.out.println(Thread.currentThread()

.getName() + " " + v)); |

| Résultat : |

ForkJoinPool.commonPool-worker-2

4

ForkJoinPool.commonPool-worker-3

2

main

3

ForkJoinPool.commonPool-worker-1

1

main

3

ForkJoinPool.commonPool-worker-3

2

ForkJoinPool.commonPool-worker-2

4

ForkJoinPool.commonPool-worker-1 1 |

La méthode unordered() permet de retirer le flag ORDERED pour indiquer au Stream que les données ne sont pas ordonnées.

Le flag ORDERED du Stream permet de préciser que les éléments sont ordonnées : il peut être positionné par la source (par exemple ArrayList ou un tableau) ou par une opération intermédiaire (par exemple sorted()). Une opération terminale peut ignorer le flag ORDERED (par exemple forEach()). La plupart des opérations intermédiaires traitent les éléments en respectant leur ordre.

Lors de l'exécution des opérations en séquentiel, avoir les éléments dans un certain ordre n'a pas d'influence sur les performances : il affecte uniquement le déterminisme du résultat en fournissant toujours le même avec la même source de données. Si les éléments ne sont pas ordonnés, différentes exécutions sur la même source peuvent donner des résultats différents.

Lors de l'exécution des opérations en parallèle, certaines opérations intermédiaires stateful ou terminales peuvent s'exécuter avec de meilleures performances (exemple distinct() ou Collectors.groupingBy()). Dans ce cas, si l'ordre des éléments n'est pas important, il peut être utile d'utiliser la méthode unordered() du Stream.

Par exemple, la méthode limit() est généralement peu coûteuse lorsque les traitements sont effectués en séquentiel mais peut être très coûteuse sur des données ordonnés avec une exécution en parallèle. Si cela n'altère pas les autres opérations, l'utilisation de la méthode unoredred() peut améliorer les performances dans des traitements en parallèle. Si l'ordre des éléments doit être conservé, l'exécution des traitements en séquentiel peut aussi améliorer les performances notamment celles de la méthode limit().

Les traitements d'un Stream sont démarrés à l'invocation de son unique opération terminale.

Une seule opération terminale ne peut être invoquée sur un même Stream : une fois cela fait, le Stream ne sera plus utilisable.

Il n'est pas possible de réutiliser un Stream une fois que son opération terminale est invoquée. Le Stream est alors considéré comme consommé. Il faut obligatoirement obtenir un nouveau Stream à partir de la source pour chaque traitement. Il n'est possible que d'invoquer une seule fois un pipeline d'opérations sur un Stream sinon une exception de type IllegalStateException est levée.

| Exemple ( code Java 8 ) : |

String[] fruits = { "orange", "citron", "pamplemousse", "banane","fraise",

"groseille", "raisin", "pomme", "poire", "abricot", "cerise", "peche", "clementine" };

Stream<String> stream = Stream.of(fruits);

stream.filter(s -> s.startsWith("p"))

.forEach(System.out::println);

try {

stream.filter(s -> s.startsWith("c"))

.forEach(System.out::println);

} catch (IllegalStateException e) {

e.printStackTrace(System.out);

} |

Cela ne pose pas de soucis pour créer un nouveau Stream à chaque fois puisque le Stream pointe simplement sur sa source de données mais ne les copie pas. Il est par exemple possible d'utiliser un Supplier pour créer des instances d'un Stream avec les mêmes éléments.

| Exemple ( code Java 8 ) : |

Supplier<Stream<String>> streamSupplier = () -> Stream.of(fruits);

streamSupplier.get()

.filter(s -> s.startsWith("p"))

.forEach(System.out::println);

streamSupplier.get()

.filter(s -> s.startsWith("c"))

.forEach(System.out::println); |

Contrairement aux opérations intermédiaires qui renvoient toujours un Stream, les opérations terminales renvoient une valeur qui correspond au résultat de l'exécution du pipeline d'opérations sur les données. Ce résultat peut être :

Il est possible qu'il n'y ait pas de résultat à l'issu des traitements d'un Stream. Java 8 propose la classe Optional qui encapsule une valeur ou l'absence de valeur.

Certaines opérations d'un Stream renvoie donc un objet de type java.util.Optional qui permet de préciser s'il y a un résultat ou non. C'est notamment le cas dans les opérations de réduction, des opérations de recherche (findXXX) ou de recherche de correspondance (XXXMatch) sur un Stream vide.

L'API Stream propose plusieurs opérations terminales dont les principales sont :

|

Méthode |

Rôle |

|

forEach |

void forEach(Consumer<? super T> action) Exécuter le Consumer sur chacun des éléments du Stream |

|

forEachOrdered |

void forEachOrdered(Consumer<? super T> action) Exécuter le Consumer sur chacun des éléments du Stream en respectant l'ordre de éléments si le Stream en défini un |

|

toArray |

Object[] toArray() Renvoyer un tableau contenant les éléments du Stream <A> A[] toArray(IntFunction<A[]> generator) Renvoyer un tableau contenant les éléments du Stream : le tableau est créé par la fonction fournie |

|

Reduce |

Optional<T> reduce(BinaryOperator<T> accumulator) Réaliser une opération de réduction qui accumule les différents éléments du Stream grâce à la fonction fournie T reduce(T identity, BinaryOperator<T> accumulator) Réaliser une opération de réduction qui accumule à partir de la valeur fournie les différents éléments du Stream grâce à la fonction <U> U reduce(U identity, BiFunction<U,? super T,U> accumulator, BinaryOperator<U> combiner) Réaliser une opération de réduction avec les fonctions fournies en paramètres |

|

collect |

<R,A> R collect(Collector<? super T,A,R> collector) Réaliser une opération de réduction avec le Collector fourni en paramètre <R> R collect(Supplier<R> supplier, BiConsumer<R,? super T> accumulator, BiConsumer<R,R> combiner) Réaliser une opération de réduction avec les fonctions fournies en paramètres |

|

min |

Optional<T> min(Comparator<? super T> comparator) Renvoyer le plus petit élément du Stream selon le Comparator fourni |

|

max |

Optional<T> max(Comparator<? super T> comparator) Renvoyer le plus grand élément du Stream selon le Comparator fourni |

|

count |

long count() Renvoyer le nombre d'éléments contenu dans le Stream |

|

anyMatch |

boolean anyMatch(Predicate<? super T> predicate) Retourner un booléen qui indique si au moins un élément valide le Predicate |

|

allMatch |

boolean allMatch(Predicate<? super T> predicate) Retourner un booléen qui indique si tous les éléments valident le Predicate |

|

noneMatch |

boolean noneMatch(Predicate<? super T> predicate) Retourner un booléen qui indique si aucun élément ne valide le Predicate |

|

findFirst |

Optional<T> findFirst() Retourner un Optional qui encapsule le premier élément validant le Predicate s'il existe |

|

findAny |

Optional<T> findAny() Retourner un Optional qui encapsule élément validant le Predicate s'il existe |

|

iterator |

Iterator<T> iterator() Renvoyer un Iterator qui permet de réaliser une itération sur tous les éléments en dehors du Stream |

|

spliterator |

Spliterator<T> spliterator() Renvoyer un Spliterator pour les éléments du Stream |

Certaines de ces méthodes sont de type short-circuiting, par exemple findFirst().

Il est possible d'exporter les éléments d'un Steam dans une collection ou un tableau en utilisant certaines de ses méthodes :

|

Méthode |

Rôle |

||

|

collect(Collectors.toList()) |

Obtenir une collection de type List qui contient les éléments du Stream

|

||

|

toArray(TypeDonnees[]::new) |

Obtenir un tableau qui contient les éléments du Stream

|

Une opération de réduction permet de traiter les éléments du Stream de manière itérative pour produire un résultat unique. Des opérations de réduction typique sur des entiers sont par exemple le calcul de la somme ou de la moyenne ou bien encore la détermination de la plus petite ou la plus grande valeur.

Une opération de réduction utilise une valeur initiale (identity) pour la combiner avec le premier élément. Le résultat est ensuite combiné avec le second élément et ainsi de suite. Les traitements utilisés pour réaliser la combinaison sont fournis sous la forme d'une fonction (accumulator).

L'application répétée de cette combinaison permet de générer le résultat qui peut prendre plusieurs formes :

L'API Stream propose des opérations de réduction :

L'API Stream propose deux opérations pour exécuter des traitements sur les éléments du résultat de l'exécution des opérations intermédiaires :

Ces deux méthodes attendent en paramètre un java.util.function.Consumer qui contient l'action à réaliser sur chacun des éléments.

Remarque : il n'est pas possible d'utiliser les instructions break ou return dans l'expression lambda pour interrompre l'itération sur les éléments.

L'exemple ci-dessous illustre les différences lors de l'utilisation de ces méthodes :

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

import java.util.Arrays;

import java.util.List;

import java.util.function.Consumer;

public class TestStream {

public static void main(String[] args) {

List<String> prenoms = Arrays.asList("andre", "benoit", "albert", "thierry", "alain");

Consumer<String> afficherElement = s -> System.out.println(s + " - " +

Thread.currentThread().getName());

prenoms.stream().sorted().forEach(afficherElement);

System.out.println();

prenoms.parallelStream().sorted().forEach(afficherElement);

System.out.println();

prenoms.parallelStream().sorted().forEachOrdered(afficherElement);

}

} |

| Résultat : |

alain - main

albert - main

andre - main

benoit - main

thierry - main

andre - main

thierry - ForkJoinPool.commonPool-worker-3

benoit - main

alain - ForkJoinPool.commonPool-worker-1

albert - ForkJoinPool.commonPool-worker-2

alain - ForkJoinPool.commonPool-worker-2

albert - ForkJoinPool.commonPool-worker-3

andre - ForkJoinPool.commonPool-worker-3

benoit - ForkJoinPool.commonPool-worker-3

thierry - ForkJoinPool.commonPool-worker-3 |

Lors de l'invocation de la méthode forEach() sur un Stream séquentiel, l'ordre des éléments n'est préservé. Bien que la méthode forEach() ne respecte aucun ordre, le parcours d'un Stream séquentiel se fait dans un unique thread ce qui permet de conserver l'ordre des éléments.

Lors de l'invocation de la méthode forEach() sur un Stream parallèle, l'ordre des éléments est pas préservé. Ceci est lié au fait de l'utilisation de plusieurs threads pour exécuter l'action sur les différents éléments.

Pour respecter l'ordre des éléments dans un Stream parallèle, il est nécessaire d'utiliser la méthode forEachOrdered() qui va réaliser l'exécution de l'action dans un thread unique. Evidemment les performances de la méthode forEachOrdered() sont moins bonnes que celles de la méthode forEach().

Il faut éviter d'utiliser ces méthodes. C'est particulièrement vrai si celles-ci effectuent des traitements qui modifient une donnée.

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

import java.util.ArrayList;

import java.util.List;

import java.util.concurrent.atomic.DoubleAdder;

public class TestEmployeStream {

public static void main(String[] args) {

List<Employe> employes = new ArrayList<>(6);

employes.add(new Employe("e1", Genre.HOMME, 176, 1500));

employes.add(new Employe("e2", Genre.HOMME, 190, 2700));

employes.add(new Employe("e3", Genre.FEMME, 172, 1850));

employes.add(new Employe("e4", Genre.FEMME, 162, 3300));

employes.add(new Employe("e5", Genre.HOMME, 176, 1280));

employes.add(new Employe("e6", Genre.FEMME, 168, 2850));

DoubleAdder total = new DoubleAdder();

employes.stream()

.forEach(e -> total.add(e.getSalaire()));

System.out.println("total salaire = " + total.doubleValue());

}

} |

| Résultat : |

total salaire = 13480.0 |

Attention : lors de l'utilisation sur un Stream parallèle, si l'action d'une opération forEach() modifie une ressource partagée, il est nécessaire de gérer explicitement les accès concurrents.

Cette approche n'est cependant pas fonctionnelle : il préférable d'utiliser une approche de type map / reduce. L'interface DoubleStream propose d'ailleurs une méthode sum() qui effectue ce traitement.

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

import java.util.ArrayList;

import java.util.List;

public class TestEmployeStream {

public static void main(String[] args) {

List<Employe> employes = new ArrayList<>(6);

employes.add(new Employe("e1", Genre.HOMME, 176, 1500));

employes.add(new Employe("e2", Genre.HOMME, 190, 2700));

employes.add(new Employe("e3", Genre.FEMME, 172, 1850));

employes.add(new Employe("e4", Genre.FEMME, 162, 3300));

employes.add(new Employe("e5", Genre.HOMME, 176, 1280));

employes.add(new Employe("e6", Genre.FEMME, 168, 2850));

Double total = employes.stream()

.mapToDouble(e -> e.getSalaire())

.sum();

System.out.println("total salaire = " + total);

}

} |

| Résultat : |

total salaire = 13480.0 |

Ces méthodes impliquent nécessairement des effets de bords puisqu'elle ne renvoie rien (void).

Pour respecter une approche fonctionnelle, il est préférable d'éviter de modifier la source de données ou ses éléments.

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

import java.util.ArrayList;

import java.util.List;

public class TestEmployeStream {

public static void main(String[] args) {

List<Employe> employes = new ArrayList<>(6);

employes.add(new Employe("e1", Genre.HOMME, 176, 1500));

employes.add(new Employe("e2", Genre.HOMME, 190, 2700));

employes.add(new Employe("e3", Genre.FEMME, 172, 1850));

employes.add(new Employe("e4", Genre.FEMME, 162, 3300));

employes.add(new Employe("e5", Genre.HOMME, 176, 1280));

employes.add(new Employe("e6", Genre.FEMME, 168, 2850));

employes.stream()

.forEach(e -> e.setSalaire(e.getSalaire() + (e.getSalaire() * 0.1)));

employes.stream()

.forEach(System.out::println);

}

} |

| Résultat : |

Employe [nom=e1, genre=HOMME, taille=176, salaire=1650.0]

Employe [nom=e2, genre=HOMME, taille=190, salaire=2970.0]

Employe [nom=e3, genre=FEMME, taille=172, salaire=2035.0]

Employe [nom=e4, genre=FEMME, taille=162, salaire=3630.0]

Employe [nom=e5, genre=HOMME, taille=176, salaire=1408.0]

Employe [nom=e6, genre=FEMME, taille=168, salaire=3135.0] |

Une meilleure approche dans ce cas, pourrait être de ne pas utiliser un Stream mais d'utiliser la méthode forEach() de la collection.

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

import java.util.ArrayList;

import java.util.List;

public class TestEmployeStream {

public static void main(String[] args) {

List<Employe> employes = new ArrayList<>(6);

employes.add(new Employe("e1", Genre.HOMME, 176, 1500));

employes.add(new Employe("e2", Genre.HOMME, 190, 2700));

employes.add(new Employe("e3", Genre.FEMME, 172, 1850));

employes.add(new Employe("e4", Genre.FEMME, 162, 3300));

employes.add(new Employe("e5", Genre.HOMME, 176, 1280));

employes.add(new Employe("e6", Genre.FEMME, 168, 2850));

employes.forEach(e -> { e.setSalaire(e.getSalaire() + (e.getSalaire() * 0.1));

System.out.println(e);

});

}

} |

Le résultat de l'exécution est le même que pour l'exemple précédent.

Les méthodes forEach() et forEachOrdered() sont des opérations terminales : une fois leur exécution terminée, le Stream est consommé et ne peux plus être utilisé. Il n'est donc pas possible d'invoquer deux fois ces méthodes sur un même Stream.

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

import java.util.stream.Stream;

public class TestStream {

public static void main(String[] args) {

Stream<Integer> nombres = Stream.of(1, 2, 3, 4, 5);

nombres.forEach(i -> System.out.println(i));

nombres.forEach(System.out::println);

}

} |

| Résultat : |

1

2

3

4

5

Exception

in thread "main" java.lang.IllegalStateException: stream has already

been operated upon or closed

at java.util.stream.AbstractPipeline.sourceStageSpliterator(AbstractPipeline.java:279)

at

java.util.stream.ReferencePipeline$Head.forEach(ReferencePipeline.java:580)

at

fr.jmdoudoux.dej.streams.TestStream.main(TestStream.java:22) |

Dans ce cas, il est possible de combiner les deux traitements dans la même expression lambda ou utiliser la méthode peek().

| Exemple ( code Java 8 ) : |

package fr.jmdoudoux.dej.streams;

import java.util.stream.Stream;